Negli ultimi mesi, Facebook ha dovuto affrontare la reazione negativa dei suoi stessi cofondatori ed ex membri dello staff. Sean Parker ha affermato che, insieme a Mark Zuckerberg, ha consapevolmente creato il social network per sfruttare un "vulnerabilità nella psicologia umana" e ha espresso preoccupazione per ciò che sta facendo al cervello dei nostri figli. Lo ha ammesso l'inventore del pulsante Mi piace, Justin Rosenstein rimpianto per aver contribuito a rendere le persone ossessionate dai social media.

Nel tentativo di riparare parte di questo danno alla reputazione e di aiutare veramente i suoi utenti, Facebook ha annunciato l’intenzione di espandere i suoi strumenti di prevenzione del suicidio.

LEGGI SUCCESSIVO: Sentirsi depresso? Come ottenere aiuto e supporto online

Non è un’iniziativa del tutto nuova – gli strumenti di prevenzione del suicidio fanno parte di Facebook da più di un decennio – ma l’azienda sta intensificando il suo gioco con l’uso dell’intelligenza artificiale. Basandosi su un recente esperimento negli Stati Uniti, Facebook sta utilizzando il pattern learning sui post precedentemente contrassegnati come suicidi, nella speranza che il sito possa intervenire anche senza una segnalazione manuale. È chiaramente una linea difficile da percorrere per quanto riguarda la privacy rispetto alla sicurezza, e quindi Facebook ha un paio di gusti per questo.

Il primo è sotto forma di spinta per gli amici degli utenti. Se l’intelligenza artificiale rileva un modello di testo che corrisponde a precedenti segnalazioni di suicidio, è probabile che l’opzione per segnalare il post per “suicidio o autolesionismo” apparirà in modo più evidente accanto ad esso, rendendo più facile l'intervento degli amici.

Vedi correlati

Sta anche testando una funzionalità che contrassegnerebbe automaticamente questi post per la revisione da parte del team operativo della comunità dell’azienda. Se i sospetti dell’IA vengono confermati da un occhio umano, il sito fornirà risorse alla persona anche senza l’intervento dei suoi amici. In un post sul suo pagina Facebook personale, Zuckerberg ha spiegato: “A partire da oggi aggiorneremo i nostri strumenti di intelligenza artificiale per identificare quando qualcuno sta esprimendo pensieri sul suicidio su Facebook in modo da poterli aiutare a ottenere rapidamente il supporto di cui hanno bisogno. Solo nell’ultimo mese, questi strumenti di intelligenza artificiale ci hanno aiutato a connetterci rapidamente con i primi soccorritori più di 100 volte.

“Con tutto il timore che l’intelligenza artificiale possa essere dannosa in futuro, è bene ricordare a noi stessi come l’intelligenza artificiale stia effettivamente aiutando a salvare la vita delle persone oggi”.

Il suicidio è una delle principali cause di morte tra i giovani e Facebook ha affermato che sta lavorando a stretto contatto Save.org, Linea di sicurezza nazionale per la prevenzione del suicidio "1-800-273-TALK (8255)", In prima linea Suicide Prevent e con i primi soccorritori per migliorare continuamente il software.

Vedi correlati

Il modo in cui le persone a rischio reagiranno a un intervento di intelligenza artificiale è una questione aperta, che potrebbe semplicemente allontanare i segnali di allarme comportamentali dagli occhi indiscreti di Facebook. L’equilibrio tra privacy e urgenza di agire è chiaramente una fonte di dibattito interno. Vanessa Callison-Burch, responsabile del prodotto Facebook detto al BBC l’azienda deve bilanciare risposte efficaci ed essere troppo invasive, ad esempio informando direttamente amici e familiari. “Siamo sensibili alla privacy e penso che non sempre conosciamo le dinamiche personali tra le persone e i loro amici in questo modo, quindi stiamo cercando di fare qualcosa che offra supporto e opzioni", ha detto spiegato.

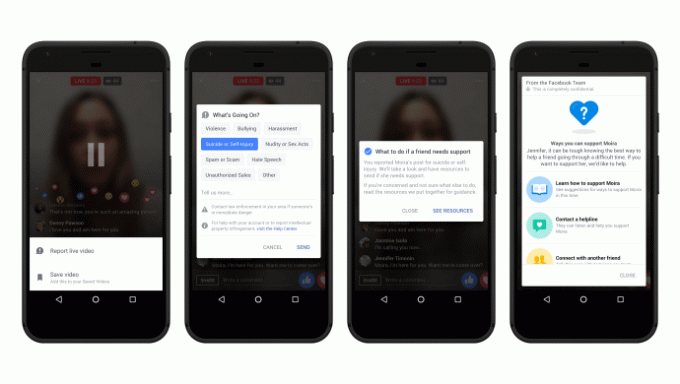

Sebbene l’intelligenza artificiale non sia stata precedentemente integrata nei servizi più in tempo reale di Facebook, la società ha cercato di rendere sia Facebook Live che Messenger più utili anche per le persone in crisi. Gli strumenti esistenti per contattare o segnalare sono stati integrati nel servizio di trasmissione live di Facebook e Messenger ora offre agli utenti la possibilità di connettersi con i servizi di supporto in tempo reale, tra cui Crisis Text Line, la National Eating Disorders Association e la National Suicide Prevention Ancora di salvezza.

In un post sul blog annunciando il recente processo, l'azienda ha spiegato le sue motivazioni: principalmente che ha il potere di fare la differenza. "Gli esperti dicono che uno dei modi migliori per prevenire il suicidio è che chi è in difficoltà ascolti le persone che si prendono cura di loro", si legge nel post sul blog. “Facebook è in una posizione unica – attraverso le amicizie sul sito – per aiutare a connettere una persona in difficoltà con persone che possono sostenerla”.

Ciò potrebbe benissimo essere vero, ma sarebbe sciocco ignorare il clima più ampio in cui sono arrivati questi aggiornamenti. Quest'anno ha già visto a numero Di riportatotrasmissioni di suicidio su Facebook Live – e anche se è possibile che questi strumenti aggiuntivi non avrebbero fatto nulla per prevenirli, non è una buona idea vedere il social network ignorare il problema.

LEGGI SUCCESSIVO: Picco di ricerche di suicidio legate a 13 Reasons Why

Non è la prima volta che Facebook utilizza l’intelligenza artificiale per cercare di renderlo un luogo più accogliente: ad aprile Nel 2016, il sito ha annunciato che utilizzava l'intelligenza artificiale per descrivere il contenuto delle immagini ai suoi utenti ipovedenti. Con tre laboratori dedicati alla ricerca sull’intelligenza artificiale e quasi due miliardi di utenti per l’intelligenza artificiale imparare da, è improbabile che questa sia l'ultima volta che Facebook tenta di risolvere un problema con la macchina apprendimento.

Inoltre, non è la prima volta che l’intelligenza artificiale viene utilizzata in questo modo nel tentativo di identificare le persone a rischio. Utilizzando un decodificatore neurale precedentemente addestrato per identificare le emozioni, così come i pensieri complessi, i ricercatori dell'Università di Pittsburgh e la Carnegie Mellon University hanno recentemente sviluppato un algoritmo in grado di individuare segni di ideazione suicidaria e comportamento.

LEGGI SUCCESSIVO: Suicidio, depressione e industria tecnologica

I ricercatori hanno applicato il loro algoritmo di apprendimento automatico alle scansioni cerebrali e il software ha identificato correttamente se una persona faceva parte di un gruppo a rischio con una precisione del 91% utilizzando i cambiamenti nei modelli di attivazione cerebrale.

Un test di follow-up ha visto l’intelligenza artificiale addestrata specificamente sulle scansioni cerebrali dei membri del gruppo collegato con pensieri suicidi per vedere se il software riusciva a identificare coloro che avevano tentato in precedenza suicidio. Era corretto nel 94% dei casi.

Se tu o una persona cara siete stati colpiti dai problemi sollevati in questa storia, potete ottenere supporto e consigli nella nostra guida in linea e guida di supporto. Puoi anche raggiungere il Samaritani gratuitamente 24 ore su 24 al numero 1116 123 o al gruppo di supporto Campagna contro la vita miserabile (CALM) dedicato ai giovani allo 0800 585858.