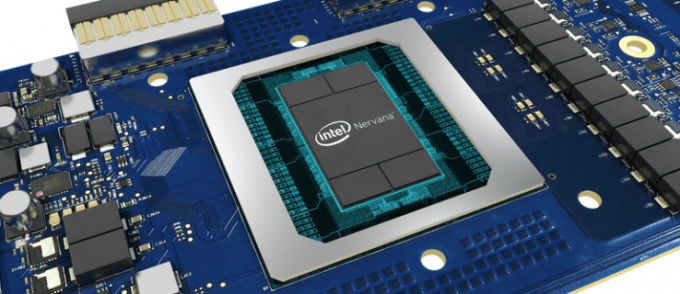

Intel a dévoilé ce qu'il appelle le processeur de réseau neuronal Nervana (NNP); la première puce disponible dans le commerce de l’entreprise, conçue dès le départ pour les applications d’apprentissage en profondeur. La révélation a également été une surprise: Intel a travaillé avec Facebook pour fabriquer son matériel dédié à l'IA.

Voir connexe

La gamme Nervana NNP, anciennement connue sous le nom de « Lake Crest », est la réponse d'Intel à l'utilisation croissante des machines. techniques d’apprentissage et une réfutation du regain d’intérêt pour le silicium de Nvidia pour les charges de travail d’IA (qui a vu les revenus de cette entreprise ont grimpé en flèche au cours de la dernière année).

Avec un chipset dédié à l'apprentissage profond, Intel espère pouvoir s'emparer du marché des centres de données IA, tout comme il s'est emparé des piles de centres de données plus traditionnels.

Le bord, par exemple, souligne qu'Intel détient une part de marché de 96 % dans les centres de données. Si l’apprentissage automatique est l’avenir, Intel veut une part de ce gâteau en constante évolution.Vous n'êtes pas sûr de la différence entre l'apprentissage automatique et l'IA? Nous avons ici une introduction pratique.

Entrez dans le Nervana NNP, qui tire parti de l’acquisition par l’entreprise en août 2016 d’une société de deep learning. Systèmes Nervana. L'année dernière, la société a payé plus de 400 millions de dollars (303 millions de livres sterling) pour la start-up d'apprentissage en profondeur de 48 personnes, et il était largement prédit qu'Intel se lancerait dans l'apprentissage en profondeur pour les centres de données.

Plus surprenant, cependant, a été la révélation selon laquelle Facebook a joué un rôle central dans la création du Nevana NNP. « Nous sommes ravis que Facebook, en étroite collaboration, partage ses connaissances techniques alors que nous apportons cette nouvelle génération de matériel d'IA sur le marché », a écrit le PDG d'Intel, Brian Krzanich, dans un article de blog, publiant parallèlement à l'annonce sur Mardi.

Intel est un peu vague sur ce que Facebook a spécifiquement proposé en termes de « perspicacité technique », mais de plus grandes capacités d’apprentissage profond sont certainement en faveur du réseau social. Un plus grand potentiel d’apprentissage automatique signifie qu’il peut faire plus en termes d’offre de pages personnalisées et prédictives aux utilisateurs. Cela signifie un ciblage plus cloisonné pour les annonceurs.

Intel reste également vague sur les vitesses exactes de sa gamme Nervana NNP. L'entreprise est jusqu'à présent seulement en disant il « vise à réduire jusqu’à 100 fois le temps nécessaire à la formation d’un modèle d’apprentissage en profondeur au cours des trois prochaines années par rapport aux solutions GPU ». L’objectif de multiplier par 100 la vitesse d’entraînement est actuellement fixé pour 2020.